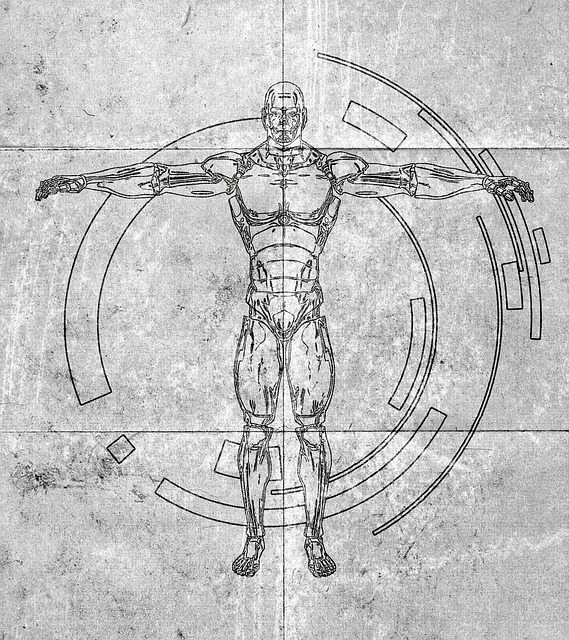

La technologie nous amène vers des endroits que la science fiction a déjà défrichés. L’intelligence artificielle n’en est qu’à ses débuts mais ils sont déjà prometteurs. Déjà, elle est implémentée dans des véhicules qui conduisent de façon (quasi) autonome. En parallèle, on développe des outils permettant à l’humain de contrôler la machine par la pensée (par ex. le projet Neuralink d’Elon Musk). Tôt ou tard, on sera confronté à la question de savoir qui est responsable lorsqu’une machine (autonome ou contrôlée par la pensée d’un humain) commet un crime ou cause un dommage.

L’utilisation d’interfaces homme-machine (IHM) n’est pas nouvelle : elle est déjà utilisée par les chercheurs pour restaurer des capacités motrices à des personnes paralysées. Cette technique est encore loin de sa maturité mais elle est très prometteuse dans le milieu médical. Plus on progresse et plus les questions éthiques se doivent d’être posées. On l’a vu avec les voitures autonomes et la question de savoir qui du passager ou du piéton la voiture autonome est censée tuer pour sauver la vie de l’autre.

En ce qui concerne le robot (au sens large) commandé par la pensée humaine, la question de la responsabilité peut être épineuse. Imaginons le cas d’une personne qui coupe du bois à la tronçonneuse. Si elle décide volontairement de couper un pilier en bois et fait s’écrouler un toit, il est évident qu’elle est responsable civilement voire pénalement des dommages et blessures causés. Mais si ladite personne manie une tronçonneuse autonome au moyen d’une IHM et ne fait que penser à couper ce pilier en bois et que la tronçonneuse autonome se met à scier ce pilier (ou un autre, par ex. celui qui se trouve le plus proche) alors que la personne n’a pas l’intention de le faire en réalité, il est plus difficile de déterminer à qui imputer la responsabilité.

En 2015, un robot informatique avait été mis au point par des étudiants suisses et achetait des articles illégaux (notamment de la drogue) sur le dark net. Il avait été saisi par la police puis rendu à ses concepteurs ; le robot et ces derniers n’ont pas été poursuivis.

Alors, qui doit-on blâmer quand un robot commet une telle faute ? Des films de science-fiction comme iRobot ou Terminator ont illustré un futur potentiel dans lequel l’humain se retrouve confronté à des robots autonomes qui commettent des exactions. Mais le droit ne jouait presque aucun rôle dans ces aperçus de notre futur (hormis par exemple les trois lois de la robotique d’Isaac Asimov). Si la présence de robots autonomes marchant parmi nous dans les rues n’est pas imminente, des machines ou technologies autonomes sont déjà utilisées aujourd’hui et sont susceptibles de servir à des fins criminelles ou peuvent causer des accidents, par erreur informatique ou sur ordre d’un humain par exemple.

Que ce soit en droit civil ou pénal, il est nécessaire pour rendre un jugement contre quelqu’un qu’il ou elle ait une personnalité juridique et soit reconnue comme une personne, physique ou morale. Ainsi, si un animal cause un dommage, son propriétaire sera tenu responsable (art. 56 CO). Pour rappel, un animal n’a pas de personnalité et est considéré comme une chose (art. 641a CC). A l’heure actuelle, sans modification légale, un robot, même une IA, est une chose et ne peut être poursuivie en droit suisse. Son propriétaire et/ou concepteur le sera à sa place (au moyen de la responsabilité du fait d’un produit, responsabilité aquilienne, pénale, etc.). Le droit pénal requiert en général qu’une infraction soit commise intentionnellement, c’est-à-dire avec conscience et volonté, ou que l’auteur savait que les conséquences de ses actes pouvaient entraîner la commission d’une infraction et ne s’est pas arrêté avant. La difficulté ici pour un procureur sera de parvenir à démontrer l’intention délictueuse ou criminelle du robot. Et qu’en sera-t-il de la peine ? Il est hautement douteux qu’un peine de prison soit une sanction adéquate pour un robot. Notre régime de sanctions n’est aucunement adapté à ce genre de situation.

Imaginons un instant qu’un robot humanoïde (qui pense et agit comme un humain) commette un meurtre. Comment allons-nous déterminer sa volonté propre de commettre un tel acte ? Appliquera-t-on la même procédure et reconnaîtra-t-on les mêmes droits à ce robot qu’aux humains ? Ou se contentera-t-on d’analyser le code qui a mené au crime ? Et dans ce cas, comment analyser l’intention de commettre le crime ? Et quid si le meurtre a été commis par un robot en état de légitime défense ?

En droit actuel, si un robot complètement autonome commet un crime, il y a de grandes chances pour que personne ne soit reconnu coupable. Le concepteur ne pourrait être condamné, s’il démontre avoir pris toutes les précautions pour éviter que la programmation du robot n’aboutisse à un tel résultat. Son propriétaire n’y serait pour rien s’il n’a donné aucune instruction dans ce sens. En tout état de cause, une responsabilité pénale serait exclue (ce qui serait difficilement admissible dans notre système juridique et notre société). Quant à une responsabilité civile, elle serait compliquée à construire (à qui imputer une faute ?).

On le voit bien, les problèmes surgiront lorsque les machines prendront des décisions de manière totalement autonome (contrairement aux voitures autonomes actuelles qui requièrent encore de par la loi une personne derrière le volant), selon leur propre perception de leur environnement. Il est ainsi primordial que le droit évolue pour prendre en compte ces changements de paradigme, notamment en ce qui concerne la responsabilité et les sanctions. La question de la reconnaissance aux robots (IA comprises) d’une personnalité juridique devra être résolue rapidement pour anticiper les problèmes que les prochaines générations de ces robots poseront à notre société.